基于Agent的情感和学习的映射的劝说模型研究

收藏

打印

发给朋友

发布者:于枝玉 胡蓉 方琳 张攀 陆可嘉

热度0票 浏览51次

时间:2022年8月01日 09:34

(100083 中国矿业大学(北京) 北京)

【摘 要】本文将情感和学习及其之间的映射关系引入到基于Agent的劝说当中,重点研究基于Agent的情感、学习映射的劝说模型。首先将Agent的情感进行分类,建立学习模型,了解影响Agent学习的因素,其中结合心理学的晕轮效应,定义Agent对于供应商的口碑、供货能力、历史合作次数;其次,量化各因素对Agent学习能力的影响程度,通过决策树建立Agent学习与情感的映射规则,从回归分析角度建立线性回归模型,并且并且利用AHP方法评价Agent学习因子对情感的影响程度。最后通过算例仿真证明了该模型的合理性和有效性,得出了相应的管理启示。

引言

近几年,商务智能逐渐引起众多企业和学者的重视,得到不断的发展和进步。在商务智能领域,自动谈判是解决人们争端和达成一致的重要途径,能够根据外部环境的动态变化实现复杂的谈判,从而节省不必要地人力物力财力 [1] 。基于Agent的劝说是自动谈判发展到更加高级和智能的阶段,将情感和学习引入到Agent的劝说模型中,使Agent除了具有逻辑运算能力之外还具有情感和学习能力,不仅能改善Agent在自动谈判时的决策能力,谈判结果更接近实际,同时也为基于Agent的劝说注入新的活力。

在基于Agent的劝说的相关研究中,孙华梅等对Agent劝说进行了分类;结合形式化理论,构建了相应的形式化表述模型和交互机制,然后将两者相结合,在让步影响幅度的基础上,构建了基于Agent劝说分类的让步模型,最后,通过算例和系统实现对模型的可行性、有效性进行了验证;该研究进行了一定程度的拓展但没有考虑Agent的学习情感特性。

Amgoud L 和 Prade H 将基于 Agent 的劝说分为威胁、奖励、解释和申辩,提出了基于以上劝说类型的逻辑框架,并对其进行了建模;但是劝说类型考虑不完全。Marcos 等针对动态劝说环境,界定了劝说中的合作者关系、接受劝说的条件、贡献关联的概念以及协作程度等,提出了基于协作的基于 Agent 的劝说模型;并未考虑Agent的学习。王春侠以电子商务谈判为背景,分别提出了基于 Agent劝说的提议和劝说的产生和评价模型。刘洁晶、李琳构建了基于 Agent的农产品交易劝说议价模型,缓解了买卖双方之间的信任冲突;只考虑农产品交易,没有拓宽到所有的商务谈判。

在基于Agent的情感的相关研究中,伍京华等对基于Agent的情感劝说的情感进行分类,依据该分类提出了相应的情感产生的形式化模型,并结合心理学的情感第一定律,对Agent情感进行量化;但是并未应用于商业谈判。祝宇虹等概括了自然情感理论及人工情感产生的意义,并详细地综合表述了人工情感的各方面研究,展望了人工情感的发展趋势。Rosales 提出了基于人类大脑功能的虚拟Agent 情感调节模型,总结了情感调节机制对行为的影响,发现了 Agent具有情感记忆的现象。Kleef 等将 Agent 的社会情感分为快乐和愤怒,认为不同社会情感状态会产生不同让步幅度。

祝宇虹,Rosales和Kleef都只进行了初步研究,但不够全面深入。董学杰将社会情感理论与模型引入基于 Agent 的劝说领域,建立了相关的社会情感决策模型,模型与实际的劝说动态变化存在一定的差异。汪矿将情感分析技术引入信任评估机制,定义了基于情感强度向量的信任表达方式,并通过仿真实验进行了验证。

在基于Agent的学习的相关研究中,张京敏利用强化学习策略中不同的参数产生提议,提出了基于中介 Agent 的强化学习劝说模型。冯楚滢等研究了协同深度学习算法(CIDL),并与其他四种算法进行实验对比, 结果表明该算法有效提升了推荐的准确性 [2] 。张京敏,冯楚滢和尚艳玲没有将学习引入基于Agent的劝说领域,因此没能很好体现Agent的人工智能优势。徐文博将强化学习算法融入团队马尔科夫博弈过程,给出了一种新的服务学习算法,实现了快速收敛。尚艳玲等结合历史信息因素,提出了一个基于多 Agent系统的 Q 值学习算法,降低了 Agent 劝说的冲突率 [3] 。申春利用贝叶斯学习、强化学习、遗传算法、模糊神经网络等学习方法,设计了相应的自动谈判策略。徐文博和申春提出新算法使自动谈判更加有效,但是他们忽略Agent的学习能力对其情感的影响。

在上述研究中对情感和学习的研究不够全面和深入,甚至没有考虑到情感和学习之间的相互影响,相比之下,本文将情感和学习及其之间的映射关系引入到基于Agent的劝说当中,重点研究基于Agent的情感、学习映射的劝说模型。

首先将Agent的情感进行分类,建立学习模型,了解影响Agent学习的因素,其中结合心理学的晕轮效应,定义Agent对于供应商的口碑、供货能力、历史合作次数;其次,量化各因素对Agent学习能力的影响程度,通过决策树建立Agent学习与情感的映射规则,从回归分析角度建立线性回归模型,并且并且利用AHP方法评价Agent学习因子对情感的影响程度。最后通过算例仿真证明了该模型的合理性和有效性,得出了相应的管理启示。

一、模型

(一)基于Agent的情感

在Agent中引入情感,可以使得Agent的谈判模拟更加符合人的思维,从而更加接近实际谈判结果,提高其有效性。

由于现实情况中谈判双方可能会存在多种情感,可根据价值的正负变化方向的不同,分为如下两类:

正向情感:人对正向价值的增加或负向价值的减少所产生的情感,如愉快、信任、感激、庆幸等。基于Agent的正向情感表现为:对谈判结果有正面影响。

负向情感:人对正向价值的减少或负向价值的增加所产生的情感,如痛苦、鄙视、仇恨、嫉妒等。基于Agent的正向情感表现为:对谈判结果有负面影响。

(二)基于aegnt的学习

在实际商务活动中,人们会通过收集相关供应商的资料,利用自身的学习能力对不同的供应商进行评价,从而影响最终的谈判结果。相应的,学习作为Agent谈判的影响因素之一,其能力大小也影响着Agent的行为决策,直接影响其行为结果。基于此,本文首先定义Agent的学习及其学习能力模型如下:

定义1 Agent的学习 是指Agent在收集并不断更新供应商相关信息的基础上,考虑谈判双方的合作特征,情感倾向和历史决策信息的基础上,对供应商进行综合评价比较,得出供应商资质的先后顺序,不断更新其学习结果,做出相应的行为决策的特性。

定义2 Agent的学习模型 是指在商务活动中,借鉴RFM模型,对Agent的学习结果进行量化计算,得出相应的值,即Agent的学习能力。建立如下Agent的学习模型:

口碑(晕轮效应,信誉度,知名度,满意度,美誉度)供货能力(供应数量,供应比率,质量,价格,售后服务)

历史合作次数(成功率,收益,满意度,信任度)C

i C

B

i B

A

i A P

V R V R V R E + + = (1)

其中

P

E 是学习能力,

C B A

R R R , ,

分别代表口碑、供货能

力、历史合作次数的权重,

C

i

B

i

A

i

V V V , ,

分别代表口碑、供货

能力、历史合作次数。

(三)映射规则

Agent的学习情况错综复杂,即使是同一个供应商,在其各学习因子权重分布不同的情况下,也可能得出不同的结论,进而影响Agent的情感结果,从而对谈判产生影响。

因此,本文为将学习与情感的映射规则进行量化,以建立Agent的学习和情感的决策树为基础,从回归分析角度建立线性回归模型。

(1)量化学习因子

RFM模型是衡量客户价值和客户创利能力的重要工具和手段。在众多的客户关系管理(CRM)的分析模式中,RFM模型是被广泛提到的。该机械模型通过一个客户的近期购买行为、购买的总体频率以及花了多少钱3项指标来描述该客户的价值状况,并且每一项指标都有1-5的5个等级。因此,在Agent的学习模型中,口碑、供货能力、历史合作次数的每个学习因子也可分为1-5的5个等级,从而实现对其学习结果的量化。

(2)建立决策树模型

机器学习中,决策树是一个预测模型;他代表的是对象属性与对象值之间的一种映射关系。树中每个节点表示某个对象,而每个分叉路径则代表的某个可能的属性值,而每个叶结点则对应从根节点到该叶节点所经历的路径所表示的对象的值。决策树仅有单一输出,若欲有复数输出,可以建立独立的决策树以处理不同输出。在本文中,将口碑、供货能力、历史合作次数视为属性,正向情感、负向情感视为对象值的不同数值,分别记作1、0,在Python中建立决策树模型,具体步骤如下:

输入:训练集D={(x 1 ,y 1 ),(x 2 ,y 2 ),(x 3 ,y 3 ),……,(x m ,y m )};

属性集A={a 1 ,a 2 ,a 3 ,……,a d }。

过程:函数TreeGenerate(D,A)

1:生成节点node;

2:if D中样本全属于同一类别C then

3:将node标记为C类叶节点;return

4:end if

5:if A = OR D中样本在A上取值相同 then

6:将node标记为叶节点,其类别标记为D中样本数最多的类;return

7:end if

8:从A中选择最优划分属性a*;

9:for a* 的每个值

10:为node 生成一个分支;领Dv表示D中在a*上取值为v

*

a 的样本子集;

11:if Dv 为空 then

12:将分支节点标记为叶节点,其类别标记为D中样本数最多的类;return

13:else

14:以TreeGenerate(Dv,A\{a* })为分支节点15:end if

16:end for

输出:以node为根节点的一棵决策树。

(三)建立回归模型

从回归分析角度建立线性回归矩阵模型,具体研究不同学习因子对情感的映射,如下所示线性回归矩阵模型:

(5)

∑ ∑

∑ ∑ ∑

?

?

=

2 2

^

) (

i i

i i i i

X X n

Y X Y X n

β

(6)

∑ ∑

∑ ∑ ∑ ∑

?

?

=

2 2

2

^

) (

i i

i i i i i

x x n

y x x y x

? (7)

( ) ( )

n

I E

2

cov , 0 σ ? ? = =

(8)

在模型中,称Y为观测向量,称 X 为设计矩阵,称β为回归系数,称μ为随机误差向量,称

( ) ( )

n

I E

2

cov , 0 σ ? ? = =

为高斯-马可夫条件 [4] 。

在回归分析中,因变量的实际值与其回归模型估计值的差称为残差,即

^

Y Y e ? =

。残差蕴含了有关模型基本假定的

许多重要信息 [5] ,残差分析就是对残差进行统计处理,从中提取相关信息来考察所给数据的适用性和模型设定的合理性。残差包含3种常见形式:普通残差、学生氏残差(标准残差)、预测残差,在本文中,选取普通残差。在回归模型中,回归参数β的最小二乘估计 Y X X X ' ) ' (1

^

?

= β ,回归方程为

^ ^

β X Y = ,从而得到随机变量Y的拟合值为;

4 4

^

3 3

^

2

^

2 1 1

^ ^

i i i i

X X X X Y β β β β + + + =

(8)

定义 ) 4 , 3 , 2 , 1 (

^

= ? = i y y e

i i i

为第 i 个观测的普通残差。如果

模型的基本假定不成立,误差项μ的分布发生了变化,这必然会导致其估计量 e 分布的变化。

(四)层次分析评价

层次分析法AHP (Analytic Hierarchy Process) 是美国运筹学家匹茨堡大学教授萨蒂(T.L.Saaty)于上世纪70年代初,为美国国防部研究“根据各个工业部门对国家福利的贡献大小而进行电力分配”课题时,应用网络系统理论和多目标综合评价方法,提出的一种层次权重决策分析方法。其主要特征是,它合理地将定性与定量的决策结合起来,按照思维、心理的规律把决策过程层次化、数量化。

该方法自1982年被介绍到我国以来,以其定性与定量相结合地处理各种决策因素的特点,以及其系统灵活简洁的优点,迅速地在我国社会经济各个领域内,如能源系统分析、城市规划、经济管理、科研评价等,得到了广泛的重视和应用。

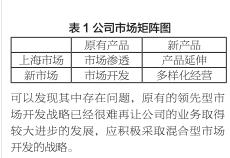

运用AHP分析问题大体要经过以下五个步骤:(1) 建立层次结构模型;(2)构造判断矩阵;(3)层次单排序;(4)一致性检验;(5)层次总排序。其中后三个步骤在整个过程中需要逐层地进行。如图1所示:

图 1 AHP分析方法

(1)建立Agent学习评价指标体系

选择“目标-准则-指标”层次结构模式,根据Agent的学习定义,考虑供应商口碑(晕轮效应、美誉度、知名度)、供货能力(供应数量、供应比率、供应速度)和历史成功合作次数(成功率、售后服务综合得分、收益率)建立层次结构模型如图 2。其中,晕轮效应又称“光环效应”,属于心理学范畴,是指当认知者对一个人的某种特征形成好或坏的印象后,他还倾向于据此推论该人其他方面的特征。

本质上是一种以偏概全的认知上的偏误。在Agent的学习中是指对于供应商的第一印象的好坏,会影响Agent在进行学习时对其口碑、供货能力的判断。

图 2 Agent的学习能力综合评价指标

(2)构造判断矩阵

构造判断矩阵 A:建立“递阶层次”结构,确定上下层元素之间的隶属关系,可采用两两比较的方法,对重要性赋予一定的数值。采用美国运筹学家 A L Saaty 教授提出的1~9 比率标度法对不同指有关 1~9 比率标度。

图 3 1-9尺度aij 的取值及其含义

例如:一级因素层对目标层 A 的判断矩阵为:

1

2

1

4

1

2 1

2

1

4 2 1

= A

(3) 求解最大特征值和其特征向量

构造出判断矩阵以后,先解出其最大特征根λmax,再利用:AW=λmax W,解出λmax 所对应的特征向量 W,特征向量 W 经过标准化后,即为同一层次中相应指标对于上一层次中某些指标相对重要性的排序权值。

(4)一致性检验

用平均随机一致性指标对于判断矩阵 A 进行一致性检验,根据各平均一致性指标,求出 A 的一致性指标指数CI,随机一致性比率 CR,若 CR<0.1,则认为 A 具有满意的一致性,否则必须重新调整 A,同理检验矩阵 B、C和D。其中,

(3)

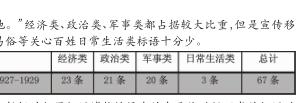

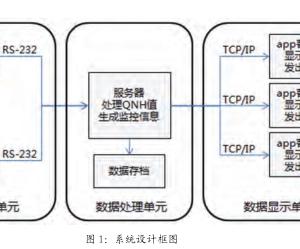

图 4 RI取值与阶数关系

(5)层次总排序

基于 Matlab 的 AHP 模型求解程序的结果算出二级因素层和三级因素层各因素的权值,可得到Agent学习能力对情感影响因素层次总排序权值如表1所示。

表1 Agent学习能力影响因素层次总排序权值

(6)结果分析

在影响Agent的学习能力的因素中,口碑的影响能力最大,其次是供货能力,最后是历史合作次数;在二级层次指标中,影响力最大的是晕轮效应,最小的是成功率。因此,在Agent的学习能力的培养过程中,要注重对供应商口碑的学习,关注供应商所展现的第一印象,避免晕轮效应。

二、算例

为了验证上述模型的可行性,假设Agent的不同学习情况与情感值,如表2所示。通过Python软件,对上述模型进行模拟,并且将模拟结果与真实结果进行对比,得出结论。

相关控制参数:口碑、供货能力、历史合作次数、学习能力参数范围由低到高为1至9,如表2所示为口碑参数示例。

以口碑参数为例,将晕轮效应、信誉度、知名度、美誉度、满意度的数值分为1-5的5个等级,因此学习因子口碑量化的范围在5-25之间,数值越高代表口碑越好。同理可获得能力和历史合作次数的量化数值,如表3所示。

晕轮效应 信誉度 知名度 美誉度 满意度

6 1 5 6 4

6 5 5 5 3

5 6 6 6 5

6 1 7 6 6

1 5 3 1 2

4 2 2 3 5

2 3 1 1 1

6 5 7 6 3

3 5 6 5 5

1 1 1 3 1

表2 口碑参数示例

口碑 供货能力 历史合作次数

19 19 15

20 17 17

23 23 19

21 20 16

11 11 9

15 15 11

8 8 7

22 20 19

20 19 16

7 7 6

表3 量化的学习因子

通过python建立学习因子与情感之间的决策树模型,如图5所示。由于本算例数据较少,得到的决策树模型较为简单。当数据量足够大时,可得到更为庞大的决策树模型。

其次,运用简单线性回归功能,分别计算口碑、供货能力、历史合作次数对情感的映射,分别得到如下公式:

∑ ∑

∑ ∑ ∑

?

?

=

2 2

^

) (

i i

i i i i

X X n

Y X Y X n

β

= 0 . 5 0 5 、 0 . 2 7 2 、

0.446、0.601,

∑ ∑

∑ ∑ ∑ ∑

?

?

=

2 2

2

^

) (

i i

i i i i i

x x n

y x x y x

? =0.126、0.112、

0.063、0.064,即

064

. 0

601

. 0

, 063

. 0

446

. 0

112

. 0

272

. 0

, 126

. 0

505

. 0

4 4

^

3 3

^

2 2

^

1 1

^

+ = + = + = + = x y x y x y x y ,

在该模型中,存在的误差为(1)基于回归:

422 . 7 , 598 . 6 , 202 . 2 , 213

. 4

) (

2

^

= ? = ∑ y y RSS

i

基于残差:

528 . 1 , 352 . 2 , 748 . 6 , 737

. 4

2

^

= ? = ∑ ) (

i i

y y ESS

总平方和:

950 . 8 , 950 . 8 , 950 . 8 , 950

. 8

) (y

2

= ? = ∑ y 说明,该模型对情感值的拟合程度较高,模型总体线性关系的显著性较强。

三、研究结论

本文将情感和学习及其之间的映射关系引入到基于Agent的劝说当中,重点研究基于Agent的情感、学习映射的劝说模型。首先将Agent的情感进行分类,建立学习模型,了解影响Agent学习的因素,其中结合心理学的晕轮效应,定义A gent对于供应商的口碑、供货能力、历史合作次数;其次,量化各因素对Agent学习能力的影响程度,通过决策树建立Agent学习与情感的映射规则,从回归分析角度建立线性回归模型,并且并且利用AHP方法评价Agent学习因子对情感的影响程度。最后通过算例仿真证明了该模型的合理性和有效性,得出了相应的管理启示。结果表明,Agent的学习因子对其情感有重要影响,通过考虑学习因子能够更好更加理性地确定情感,与已有研究对比,本文所作出的改进如下:

提出了基于 Agent 的学习的概念,并研究了根据 Agent的学习进行情感劝说选择问题。学习是人类获取文化知识并且更新知识的途径,人们在学习之后会产生不同的情感效应,而所产生的情感的好坏会影响双方谈判的结果。因此通过 Agent 模拟人的学习,考虑衡量备择 Agent 主体与Agent 的学习,选择合适的谈判方式,更加符合人类思维和逻辑,对于劝说过程及可能进行的长期合作具有重要影响。

进入线性回归矩阵,从回归分析角度建立线性回归模型,运用数学方法定量学习及学习因子对情感的作用规则,并且考虑模型参数的最小二乘估计和假设检验,进行误差分析,确定该模型的正确性。回归分析可以准确地计量各个因素之间的相关程度与回归拟合程度的高低,提高预测方程式的效果。

在进行映射规则评价时采用AHP评价方法,处理定性和定量相结合的问题,将决策者的主观判断与政策经验导入模型,并加以量化处理。本文考虑供应商口碑(晕轮效应、美誉度、知名度)、供货能力(供应数量、供应比率、供应速度)和历史成功合作次数(成功率、售后服务综合得分、收益率)建立层次结构模型,逐层分解,在多个单准则评价的基础上进行综合,挖掘出深层次的、实质性的综合信息作为决策支持。

本文提出的模型具有较好的一般性,对企业的运营管理具有实际指导意义。实际的商务谈判处于实时变化的动态环境,而通过开发相应的人工智能谈判系统,能够在一定程度上提升自动谈判的针对性和适应性。现有研究中虽然引入了相关智能算法并建立了相应的基于 Agent 的劝说的产生模型,但是没有考虑在劝说动态变化影响下的 Agent 的劝说。本文引入学习的形式化模型,了解影响Agent学习的因素,其中结合心理学的晕轮效应,定义Agent对于供应商的口碑,并且利用RFM方法量化各因素对Agent学习能力的影响程度,以Agent的学习与情感映射矩阵为基础,从回归分析角度建立线性回归模型。因此,本文的研究既借助了AHP是强有力的系统分析,对多因素、多标准、多方案的综合评价及趋势预测相当有效的特点,还利用了 Agent 的学习能 力的商务智能特性,综合考虑了 Agent 的情感行为决策,从而保证了所构建模型的全局寻优速度更快。综上,企业还可以结合各自的经营模式与特色,创建相应的自动谈判系统,既能节约成本,又能提高效率,保证效果。

参考文献:

[1] Francesco Marino, Corrado Moiso, Matteo Petracca.

Automatic contract negotiation, service discovery and mutualauthentication solutions: A survey on the enabling technologies ofthe forthcoming IoT ecosystems[J]. Computer Networks, 2019, 148:

176-195.

[2] Jinyu Zhang, Xuechun Luo, Yao Zhou,et al. Two-waynegotiation for intelligent hotel reservation based on multiagent: Themodel and system[J]. Knowledge-Based Systems, 2018, 161(1): 78-89

[3]伍京华,王竞陶,刘浩,叶慧慧.基于Agent的情感映射的劝说模型及系统[J/OL].计算机集成制造系统:1-34[2019-11-01].

http://kns.cnki.net/kcms/detail/11.5946.TP.20190916.0940.010.

html.

[4]伍京华,许陈颖,陈虹羽.基于 Agent 的社会情感学习及其行为决策的劝说提议产生模型.

[5]孙华梅,伍京华,黄梯云,贺根.一种基于Agent劝说分类的让步模型及实现[J].运筹与管理,2014,23(06):252-256.

[6] Amgoud L, Prade H. Generation and Evaluation ofDifferent Types of Arguments in Negotiation[C]. InternationalWorkshop on Non-Monotonic Reasoning. DBLP, 2004.10-15.

[7]Marcos M J, Falappa M A, Simari G R. Dynamicargumentation in abstract dialogue frameworks[C]. InternationalConference on Argumentation in Multi-Agent Systems. Springer-Verlag, 2010.228-247.

[8]王春侠. 基于 Agent 的辩论谈判中的辩论机制研究[D].

北京工业大学, 2013.

[9]刘洁晶, 李琳. 基于 Multi-Agent 的农产品电子商务交易模型[J]. 衡水学院学报, 2016, 18(4):5-7.

[10]伍京华,许陈颖,张富娟.基于Agent的情感劝说的合作主体选择模型[J].管理工程学报,2019,33(01):230-237.

[11]祝宇虹, 魏金海, 毛俊鑫. 人工情感研究综述[J]. 江南大学学报(自然科学版), 2012, 11(4):497-504. ZhuY H, Wei J H,Mao J X. Summary of Artificial Emotion[J]. Journal of JiangnanUniversity( Natural Science Edition) , 2012, 11(4):497-504.

[12]Rosales J H, Jaime K, Ramos F, et al. An emotionalregulation model with memories for virtual agents[M]. 2013[13]Kleef G A V, Dreu C K W D, Pietroni D, et al. Power andemotion in negotiation: power moderates the interpersonal effects ofanger and happiness onconcession making[J]. European Journal ofSocial Psychology, 2010, 36(4):557-581.

[14] 董学杰.基于情感模型的辩论谈判系统研究[D].北京:北京工业大学, 2013. Dong X J. Research on ArgumentationBased Negotiation System Using Emotion Model[D].Beijing: BeijingUniversity of Technology, 2013

[15]汪矿. 基于情感强度感知的动态信任评估机制研究[D]. 南京邮电大学, 2016.

[16]张京敏, 董红斌. 基于中介 Agent 的强化学习优化协商模型[J]. 计算机科学, 2017, 44(1):53-59. Zhang J M, Dong H B.

Optimized Negotiation Model Based on Reinforcement Learning ofMedium Agent[J]. Computer Science, 2017, 44(1):53-59.